Innovazioni nella Generazione di Codice: La Rivoluzione dei Modelli di Contesto Esteso

Nel panorama attuale dello sviluppo software, uno dei principali ostacoli con cui i programmatori devono confrontarsi è la gestione di basi di codice complesse. Questi enormi insiemi di codice richiedono una comprensione approfondita delle relazioni e delle dipendenze tra le varie porzioni di codice. Per anni, i modelli di intelligenza artificiale tradizionali hanno faticato a supportare adeguatamente gli sviluppatori in questo compito. Tuttavia, l’introduzione di modelli di contesto lungo, come Gemini 1.5 Flash e Pro, ha portato a un livello senza precedenti di precisione e utilità nella generazione di codice.

Collaborazione con Sourcegraph e Cody AI

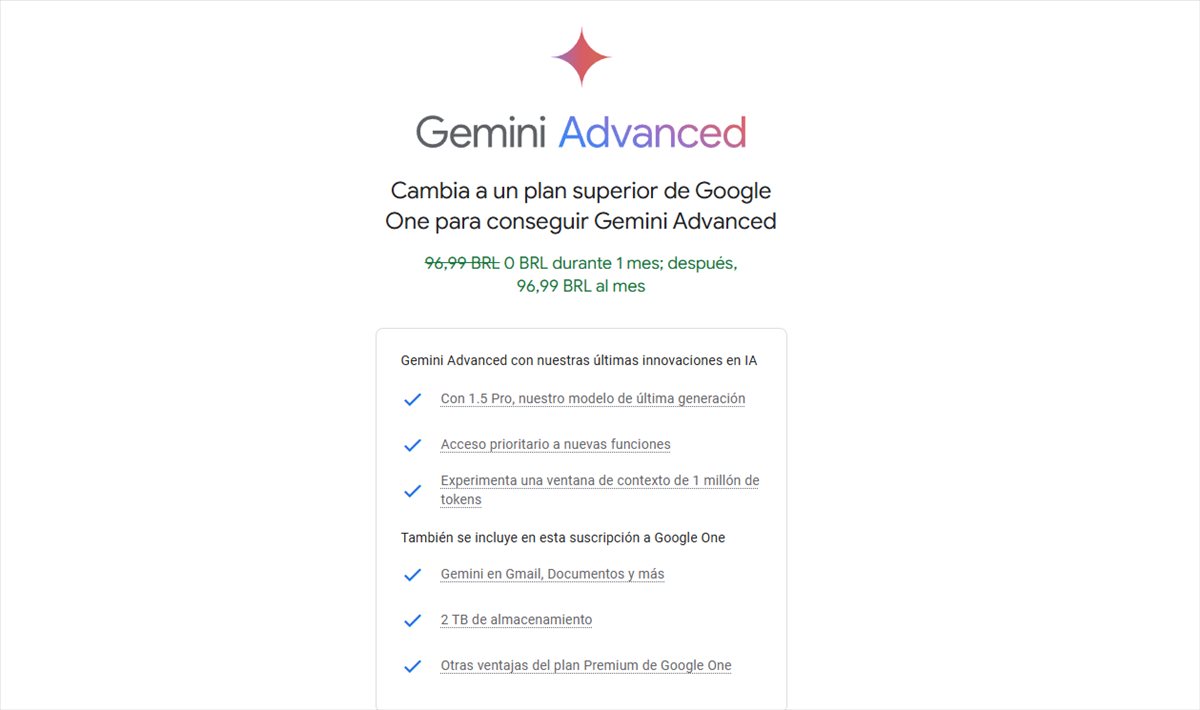

In un interessante progetto di collaborazione, è stata esplorata la potenzialità di questi avanzati modelli di contesto prolungato a fianco di Sourcegraph, ideatori dell’assistente di codifica Cody AI. Cody, che già sfrutta Large Language Models (LLMs) evoluti, è stato sottoposto a una serie di test comparativi per valutare l’impatto di un contesto di ben 1 milione di token sulle sue performance nel campo della generazione di codice, specialmente in ambienti aziendali ad alta complessità.

Risultati dell’Integrazione con Sourcegraph

Sourcegraph ha effettuato un confronto diretto tra la versione standard di Cody e quella che integrava il contesto esteso di Gemini 1.5 Flash. L’obiettivo era rispondere a domande tecniche di rilevante complessità, necessitando di una profonda comprensione del codice. I risultati ottenuti sono stati decisamente sorprendenti:

- Essential Recall: Si è osservato un significativo aumento nella proporzione di fatti cruciali forniti nelle risposte, dimostrando un netto miglioramento nella capacità di recuperare e presentare informazioni rilevanti.

- Essential Concision: La relazione tra fatti essenziali e la lunghezza delle risposte è migliorata, portando a comunicazioni più concise e utili per gli sviluppatori.

- Helpfulness: Anche il punteggio di utilità generale ha mostrato un incremento, offrendo un’esperienza molto più ricca e proattiva per gli utenti.

Un ulteriore vantaggio è stata la drastica riduzione nella tassa di alucinazioni, che misura la generazione di informazioni errate. Questa è scesa dall’18.97% al 10.48%, migliorando così la precisione e l’affidabilità delle risposte fornite da Cody.

Analisi delle Sfide e Ottimizzazione

Nonostante i notevoli benefici portati dall’integrazione di modelli di contesto lungo, permangono alcune sfide, in particolare legate ai tempi di risposta. È stato riscontrato che il tempo necessario per ricevere il primo token tende ad aumentare linearmente con la lunghezza del contesto. Per affrontare tale problematica, Sourcegraph ha implementato un innovativo meccanismo di prefetching e una architettura di modello a strati per la cache degli stati di esecuzione. Grazie a queste ottimizzazioni, il tempo di attesa per contesti di 1MB è stato ridotto da 30-40 secondi a circa 5 secondi, consentendo così un supporto quasi in tempo reale.

Il Futuro della Codifica Assistita da Intelligenza Artificiale

Queste innovazioni evidenziano chiaramente come i modelli di contesto esteso come Gemini 1.5 possano trasformare radicalmente il sviluppo software, in particolare in scenari dove rapidità e precisione sono di fondamentale importanza. La collaborazione con aziende all’avanguardia come Sourcegraph dimostra che, con la tecnologia appropriata, i problemi legati alla gestione di ampie basi di codice possono trasformarsi in opportunità per migliorare la produttività e la qualità del lavoro.

Dal nostro punto di vista, questi progressi non solo aprono nuove porte per applicazioni più innovative nel campo dell’intelligenza artificiale e della programmazione, ma pongono anche interrogativi su quali saranno i prossimi sviluppi. Qual è il limite di queste tecnologie? Solo il tempo potrà dirlo, ma il potenziale è già tangibile e non possiamo fare altro che guardare avanti con entusiasmo.

Marco Stella, è un Blogger Freelance, autore su Maidirelink.it, amante del web e di tutto ciò che lo circonda. Nella vita, è un fotografo ed in rete scrive soprattutto guide e tutorial sul mondo Pc windows, Smartphone, Giochi e curiosità dal web.